1x1卷积核

https://blog.csdn.net/YOULANSHENGMENG/article/details/120908575\

是什么

通过一次卷积操作,W

5个卷积核,每个卷积核的尺寸是1

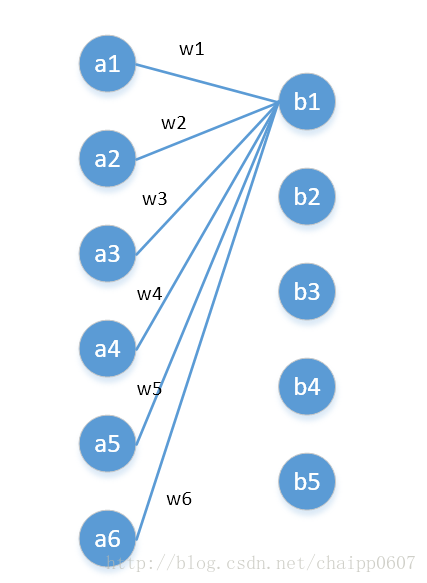

第一层有6个神经元,分别是a1—a6,通过全连接之后变成5个,分别是b1—b5,第一层的六个神经元要和后面五个实现全连接,本图中只画了a1—a6连接到b1的示意,可以看到,在全连接层b1其实是前面6个神经元的加权和,权对应的就是w1—w6,到这里就很清晰了:

第一层的6个神经元其实就相当于输入特征里面那个通道数:6,而第二层的5个神经元相当于1

w1—w6是一个卷积核的权系数,如何要计算b2—b5,显然还需要4个同样尺寸的核。

图像的一层相比于神经元还是有区别的,这在于是一个2D矩阵还是一个数字,但是即便是一个2D矩阵的话也还是只需要一个参数(1

好处

1,灵活的控制特征图的深度;

2,减少参数

降维,其实也是减少了参数,因为特征图少了,参数也自然跟着就减少,相当于在特征图的通道数上进行卷积,压缩特征图;

3,二次提取特征,使得新特征图的特征表达更佳

4, 现了跨通道的信息组合,并增加了非线性特征

使用11卷积核,实现降维和升维的操作其实就是channel间信息的线性组合变化,实现了通道间的信息交互。因为11卷积核,可以在保持feature map尺度不变的(即不损失分辨率)的前提下大幅增加非线性特性(利用后接的非线性激活函数),把网络做的很deep,增加非线性特性。

conclusion

1